| 一文详解激光雷达原理之光学原理 | 您所在的位置:网站首页 › 激光雷达光源选择参数 › 一文详解激光雷达原理之光学原理 |

一文详解激光雷达原理之光学原理

|

来源丨新机器视觉 点击进入—>3D视觉工坊学习交流群 之前我们讲到激光雷达根据接收原理一般分为iTOF/ dTOF(SPAD/ APD),根据扫描方式又可以分为机械旋转式激光雷达/ 半固态(有的也叫混合固态)激光雷达/ 固态激光雷达/ Flash/OPA 等等,这个以后会讲到(又给自己挖坑了hhh)。但他们的最小组成单元比较类似:发射端:光源+发射透镜,接收端:sensor+接收透镜。本文基于目前较多的机械旋转式/混合固态式,讲讲其中的光学原理 光源 激光雷达的光源当然是激光,常用的一般两个波段 905nm波段通常是用EEL(Edge-Emitting Laser)边发射激光器,VCSEL(Vertical-Cavity Surface-Emitting Laser)垂直腔面发射激光器。 1550nm波段,通常需要用到光纤激光器。 波长的选择 为什么会用到这两个波段呢,主要是根据两方面的约束

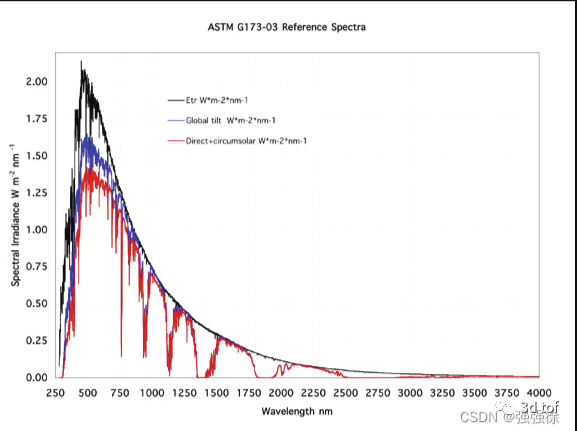

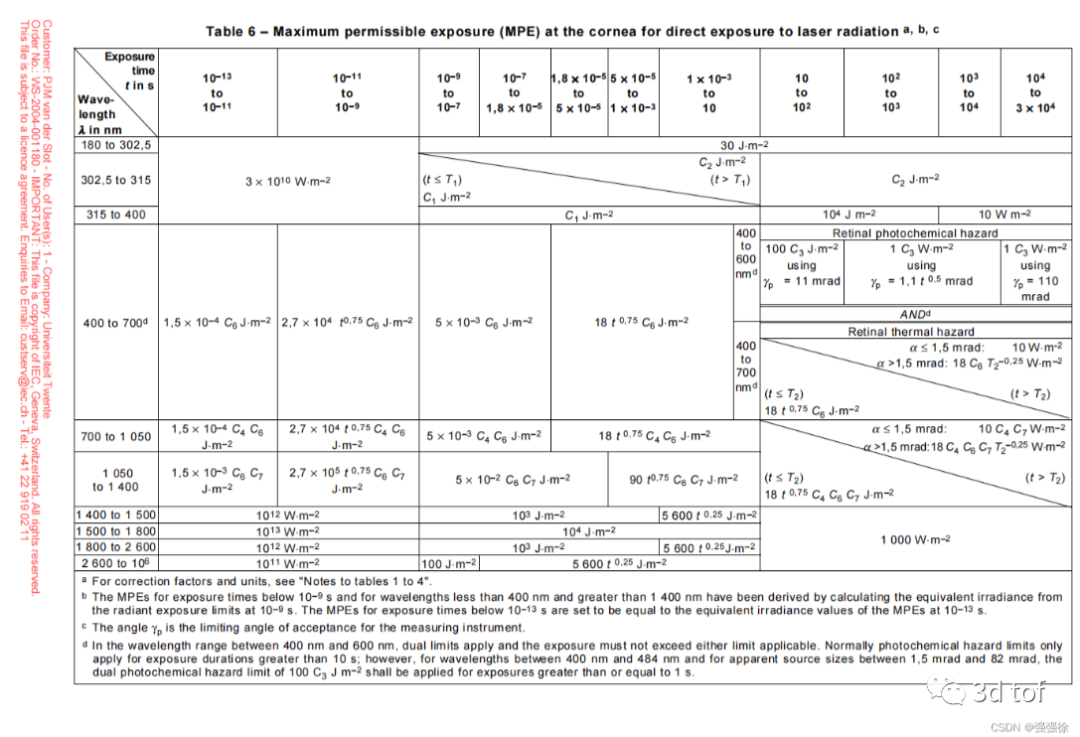

自然光的光谱 905nm也好,1550nm也好,在自然光光谱中占比重较小,即在相同的自然光强下,这个波段的强度较低,使得经过滤光片过滤后,噪声较小。这个自然光光谱的具体数值可以通过ASTM G173查到,我之后会看一下这里能否上传文件,可以的话我会上传上去,大家可以在我的主页找找。 人眼安全 参考IEC60825-1 消费级的激光雷达都会要求人眼安全级别达到class 1,人眼安全除了跟激光的能量强度、FOV、脉冲时间、脉冲峰值功率、平均光功率有关外,还和波长相关。

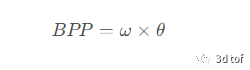

1550nm的激光会被晶状体和角膜吸收,所以在class 1的标准下,使用1550nm的光源可以使用更高的功率。当然1550nm的光源也有其他的优劣,成本,特定场景下回波能量低之类的,先不在这里展开了。同样的,IEC60825-1也有相关文件,我会看看是否可以上传。 光束质量 因为光源是激光,是存在快慢轴(快轴是垂直于激光芯片正表面的,慢轴是平行于芯片表面的,一般快轴的发散角大,慢轴反之)和束腰的,所以激光光束质量的好坏是光源选择的关键。判断激光光源光束质量的常用表达方式是BPP(Beam-Parameter Product)光参数积(当然还有M^2,这里就讲BPP吧),BPP的定义:

其中ω 是束腰半径,θ 是远场发散半角。BPP是一个恒定值,在不损失能量的情况下,利用光学系统对激光的任意一项进行调整,另一项都会发生相应的改变。可以看出,BPP越小,光束能量越集中,光束质量就越好。 而因为部分激光雷达(如车载)有远距离测距的要求,为了保证足够的分辨率,需要激光的弥散斑在远距离也保持的很小,所以需要将激光的出射角准直到很小(这里会在下文出射透镜环节进一步讲),而又为了回波能量能够被探测到,所以需要其能量足够集中吗。所以选择一个BPP很小的激光器是关键的。 EEL vs VCSEL vs 光纤激光器 这里用个表格来表示吧:

中心波长偏移 通常温度的变化会给激光器的中心波长带来变化,不同批次的激光器中心波长也会有一定程度的便宜,这使得对滤光片的带宽要求变宽,从而会让更多的环境光作为噪声进入sensor,减小信噪比。 发射透镜 发射透镜主要是为了准直,因为光源是激光,快慢轴需要用柱面镜分开单独准直(当然对于快慢轴发散角一致的光源来说可以用一个凸面镜来准直),准直后的发散角一般用m r a d mradmrad(毫弧度)为单位来表示。相同能量下,发散角越小,激光雷达能测到的距离就更远,测距分辨率越高。 接收透镜 接收透镜与Sensor的类型有关,如果Sensor只有单个pixel,那么接收透镜是非成像的,只用FOV与发射透镜匹配即可。 如果是面阵的Sensor,那就和camera透镜的方式一致,物像关系需要对应。 Sensor Sensor的种类之前讲过了(不过也还有FMCW OPA没讲),当然不同波长的光源,选用的Sensor也有所不同。 光路分类 主要分两种方式:旁轴&同轴 这里我画了两张图(是不是很用心,没在网上找了) 旁轴系统

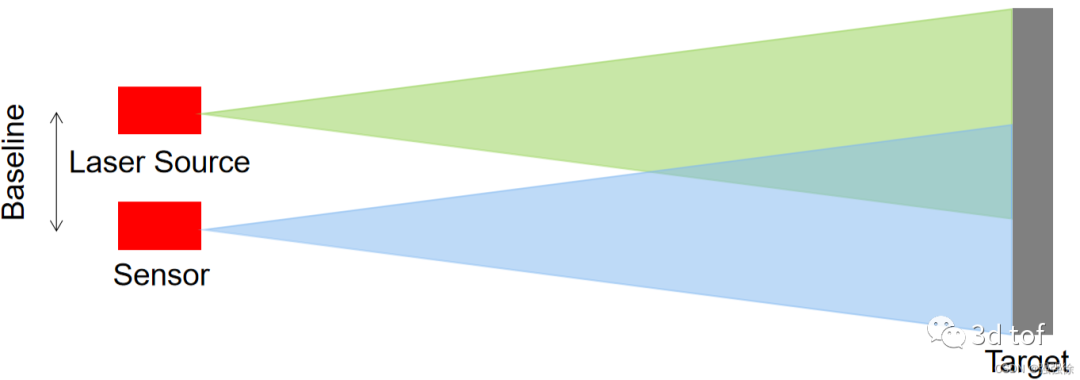

发射端和接收端是不同的光路,发射端和接收端之间的物理距离被称为Baseline,Baseline的大小,光源和发射透镜组成的发射端的发散角,Sensor和接收透镜组成的接收端的视场角,共同决定了旁轴光路系统的有效测距范围(可以用简单的三角关系来计算)。可以看出,旁轴系统在近距离是存在盲区的(即近距离是无法测距的,而其实因为发散角的边缘并不是完全无光(定义为1 / e^2的位置),所以因为SPAD的高感光能力,SPAD应用中近距离的盲区会远小于理论盲区)。所以,考虑到分辨率和盲区大小,旁轴系统会希望Baseline尽可能的小,发射端的发散小要尽可能的小,而接收端的视场角需要略大于发射端,但不能大太多(因为大太多会引入更多的环境噪声)。对于同样一个目标靶来说,旁轴系统接收到的能量随着距离的远近的线性度会较差,且会因为极线约束在sensor靶面上的投影也会随距离偏移(而大多数sensor不同位置对于能量的响应也是有所不同的)。 同轴系统

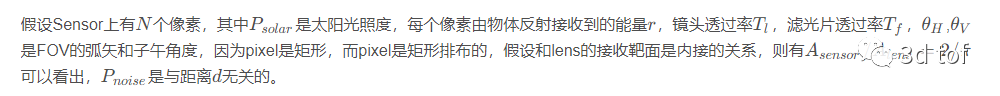

发射端和接收端是相同光路的系统,利用分光镜来对发射/接收光线进行半透半反,因为是相同的光路,发射和接收的角度可以做到相同,且不存在盲区,同轴的系统不存在极线约束,其能量随距离的线性度也会更好。然而因为分光镜的存在,同轴系统对于光源能量的要求更高(在图中也很好看出,出射能量会被削弱50%,接收能量又会被削弱50%)。且同轴系统的装配难度及体积也会比旁轴系统要大。 PS. 这里引入了一个reference sensor的概念,因为温漂会影响发射系统的出光延时,所以只记录电路上的start 出光信号时间会受到温度的影响使得测距的信息不准确,而光的start 信号出光延时是同步的,所以利用reference sensor可以更好的跟随温漂后的实际出光时间,获得更准确的start时间,从而抑制温漂对TOF测距产生的影响。 光学链路分析 分析方式各种paper没有太过统一,但大致需要考量的因素差不太多。我会分为两块来讲讲我的理解 背景噪声建模 《Modeling and Analysis of a Direct Time-of-Flight Sensor Architecture for LiDAR Applications》这篇文章提到可以用普朗克黑体辐射定律和泊松分布来建模

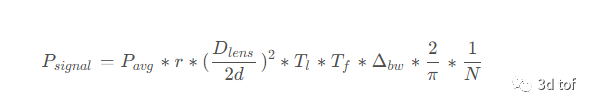

信号/回波衰减建模

其他 当然,这里是简单的模拟,像目标物反射可以用朗伯散射的模型,IR的透过率引入IR的带通数值以及太阳光的光谱数据(根据刚才提到的ASTM G173),发射与接收之间的baseline以及弧面光功率到平面目标物的散射截面积,如SPAD的雪崩触发的泊松/负二项分布,电路的散弹噪声/暗电流/热电流都可以被考虑到。 ———————————————— 版权声明:本文为CSDN博主「强强徐」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。 原文链接:https://blog.csdn.net/weixin_38644037/article/details/128493555 本文仅做学术分享,如有侵权,请联系删文。 点击进入—>3D视觉工坊学习交流群 干货下载与学习 后台回复:巴塞罗那自治大学课件,即可下载国外大学沉淀数年3D Vison精品课件 后台回复:计算机视觉书籍,即可下载3D视觉领域经典书籍pdf 后台回复:3D视觉课程,即可学习3D视觉领域精品课程 3D视觉工坊精品课程官网:3dcver.com 1.面向自动驾驶领域的3D点云目标检测全栈学习路线!(单模态+多模态/数据+代码)2.彻底搞透视觉三维重建:原理剖析、代码讲解、及优化改进3.国内首个面向工业级实战的点云处理课程4.激光-视觉-IMU-GPS融合SLAM算法梳理和代码讲解5.彻底搞懂视觉-惯性SLAM:基于VINS-Fusion正式开课啦6.彻底搞懂基于LOAM框架的3D激光SLAM: 源码剖析到算法优化7.彻底剖析室内、室外激光SLAM关键算法原理、代码和实战(cartographer+LOAM +LIO-SAM) 8.从零搭建一套结构光3D重建系统[理论+源码+实践] 9.单目深度估计方法:算法梳理与代码实现 10.自动驾驶中的深度学习模型部署实战 11.相机模型与标定(单目+双目+鱼眼) 12.重磅!四旋翼飞行器:算法与实战 13.ROS2从入门到精通:理论与实战 14.国内首个3D缺陷检测教程:理论、源码与实战 15.基于Open3D的点云处理入门与实战教程 16.透彻理解视觉ORB-SLAM3:理论基础+代码解析+算法改进 17.机械臂抓取从入门到实战 重磅!粉丝学习交流群已成立 交流群主要有3D视觉、CV&深度学习、SLAM、三维重建、点云后处理、自动驾驶、多传感器融合、CV入门、三维测量、VR/AR、3D人脸识别、医疗影像、缺陷检测、行人重识别、目标跟踪、视觉产品落地、视觉竞赛、车牌识别、硬件选型、ORB-SLAM系列源码交流、深度估计、TOF、求职交流等方向。 扫描以下二维码,添加小助理微信(dddvisiona),一定要备注:研究方向+学校/公司+昵称,例如:”3D视觉 + 上海交大 + 静静“。请按照格式备注,可快速被通过且邀请进群。原创投稿也请联系。

▲长按加微信群或投稿,微信号:dddvisiona 3D视觉从入门到精通知识星球:针对3D视觉领域的视频课程(三维重建系列、三维点云系列、结构光系列、手眼标定、相机标定、激光/视觉SLAM、自动驾驶等)、源码分享、知识点汇总、入门进阶学习路线、最新paper分享、疑问解答等进行深耕,更有各类大厂的算法工程人员进行技术指导。与此同时,星球将联合知名企业发布3D视觉相关算法开发岗位以及项目对接信息,打造成集技术与就业为一体的铁杆粉丝聚集区,6000+星球成员为创造更好的AI世界共同进步,知识星球入口: 学习3D视觉核心技术,扫描查看,3天内无条件退款

高质量教程资料、答疑解惑、助你高效解决问题 觉得有用,麻烦给个赞和在看~ |

【本文地址】