| 【Pytorch/Pycharm】3090/4090训练踩坑记录 | 您所在的位置:网站首页 › 3090双显卡 › 【Pytorch/Pycharm】3090/4090训练踩坑记录 |

【Pytorch/Pycharm】3090/4090训练踩坑记录

|

最近在用3090/4090进行深度学习的框架训练,但是在训练过程中踩了一个前所未有的坑,在网络上找了好久也没有个定论,就先记录一下。 问题描述:将电脑环境配置完成之后,分别在两个主机上进行了多次的代码实验,每次都能顺利进行,GPU的利用率、显存占用率、显卡功率都处于一个比较正常的状态,如下图。 但是后面不知道是因为训练时间过久or电脑太久没有重启了,突然电脑就类似于重新启动,pycharm什么的都闪退了,然后再接着进行训练的时候,就发现原来的一个Epoch需要15mins,就突然变成了1个小时,在这种情况下我得两台主机显示出两种不同的状态。总结来说:显卡显存拉满,显卡功率正常/功率上不去,训练速度相比于正常来说差了十万八千里。 3090: 在cmd中输入nvidia-smi显示如下:跟上面正常运行感觉没什么差别,除了显卡功率略低一点。但是在pycharm中就是显示需要一个小时才能跑完一个epoch。

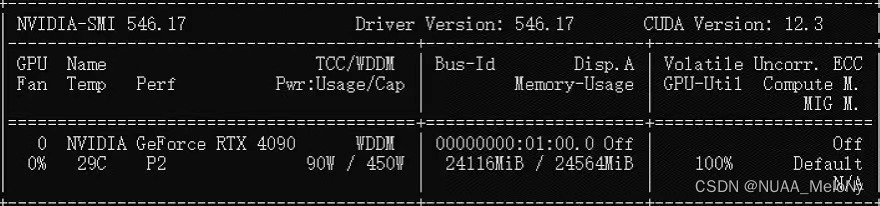

在cmd中输入nvidia-smi显示如下:一个跟3090的明显的对比就是显卡功率居然只有90W,pycharm显示需要5个小时才能跑完一个epoch。

尝试解决方法1:重启电脑 第一想法肯定是重启电脑,然后分别重启了两台电脑,得到的结果还是一样的。 尝试解决方法2:显卡性能检测 以为自己高强度训练把显卡干烂了(4090才开始使用以为买到假的了),然后分别跑了甜甜圈,把显卡电源线重新拔插,发现在显卡根本没问题,跑甜甜圈显卡功率使用率全能上去,证明显卡没问题。 尝试解决方法3:重新配置环境 在4090那台机器重新进行了环境配置,发现还是一样的问题。但是更加玄学的来了,我用我的框架跑数据集A正常训练(说明代码没问题),在另一个数据集B跑别的框架也能正常训练(说明环境没问题),但是用我的自己的网络框架跑数据集B就是不能正常训练。后续调试了代码也没有成功。 最终解决方法:显卡驱动重新安装将上面的所有问题排查一遍之后,实在不知道该怎么做了,就觉得是显卡驱动的问题,然后去官网下载了最新的驱动,重启电脑后,就可以正常的训练了。 很玄学。因为跑了一年多的深度学习头一次遇到这样的问题,才网上搜索也没有什么答案(可能提问方式不对),所以就记录一下! |

【本文地址】