| 使用scrapy框架爬取携程旅行数据 | 您所在的位置:网站首页 › 使用Python爬取携程旅游游记文章 › 使用scrapy框架爬取携程旅行数据 |

使用scrapy框架爬取携程旅行数据

|

文章目录

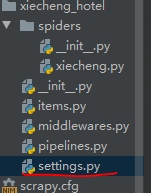

目录 使用scrapy框架爬取携程旅行数据 文章目录 scrapy 基本概念 一、scrapy框架的基本使用 1.两种比较方便的安装scrapy框架的cmd命令 2.测试是否安装完成scrapy框架 3.创建一个scrapy工程的cmd命令 4.使用cmd命令创建scrapy模板 5.cmd命令启动scrapy模板 6.我们也可以在pycharm中编写__init__文件来启动scrapy模板 7.最终完成的工程蓝图 二、使用步骤 1.引入库 2.对不同的网页地址和地区格式化为相应的url 3.设置请求头使用fake_useragent来产生随机代理 Cookie是必不可少的 4.start_requests(self) 中对所产生的url进行逐个获取数据 5.对不同页面获取的html使用正则表达式来获取json数据 6.我们遇到的第一个错觉 7.处理好和采集出我们想要的数据后需要把数据放入数据库中,这里我采用mysql来存储数据 8.我们来测试代码........... 总结 1.使用scrapy框架方便了我们对页面数据的获取和,对海量url我们可以开启线程,不过一定要遵守网络安全法 2.改文章只提供学习,不可使用数据进行售卖,尊重别人的知识产权 scrapy 基本概念Scrapy是由Twisted写的一个受欢迎的python事件驱动网络框架,它使用的是非阻塞的异步处理。 1.内部各组件的作用 ScrapyEngine(scrapy引擎):是用来控制整个系统的数据处理流程,并进行事务处理的触发。 Scheduler(调度器):用来接收引擎发过来的请求,压入队列中,并在引擎再次请求的时候返回。它就像是一个URL的优先队列,由它来决定下一个要抓取的网址是什么,同时在这里会去除重复的网址。 Downloader(下载器):用于下载网页内容,并将网页内容返回给爬虫(Spiders)(Scrapy下载器是建立在Twisted这个高效的异步模型上的)。 Spiders(爬虫):爬虫主要是干活的,用于从特定网页中提取自己需要的信息,即所谓的实体(Item)。也可以从中提取URL,让scrapy继续爬取下一个页面。 Pipeline(项目管道):负责处理爬虫从网页中爬取的实体,主要的功能就是持久化实体、验证实体的有效性、清除不需要的信息。当页面被爬虫解析后,将被送到项目管道,并经过几个特定的次序处理数据。 Downloader Middlewares(下载器中间件):位于scrapy引擎和下载器之间的框架,主要是处理scrapy引擎与下载器之间的请求及响应。设置代理ip和用户代理可以在这里设置。 Spider Middlewares(爬虫中间件):位于scrapy引擎和爬虫之间的框架,主要工作是处理爬虫的响应输入和请求输出。 Scheduler Middlewares(调度中间件):位于scrapy引擎和调度器之间的框架,主要是处理从scrapy引擎发送到调度器的请求和响应。 2.Scrapy运行流程 引擎从调度器中取出一个URL用于接下来的抓取 引擎把URL封装成一个请求(Request)传给下载器 下载器把资源下载下来,并封装成一个响应(Response) 爬虫解析Response 解析出的是实体(Item),则交给项目管道(Pipeline)进行进一步的处理 解析出的是链接(URL),则把URL交给调度器等待下一步的抓取 3.基本流程图

代码如下(示例): import scrapy import json import re import time import fake_useragent import urllib.parse 2.对不同的网页地址和地区格式化为相应的url代码如下(示例): city = ['广东', '广州', '珠海', '广州长隆旅游度假区', '珠海长隆旅游度假区', '深圳', '佛山', '顺德区', '汕头', '潮州', '南澳', '惠州', '清远', '惠东', '英德', '东莞', '巽寮湾', '福建', '广西', '澳门', '连州', '厦门', '连南', '鼓浪屿', '江门', '桂林', '海南', '韶关', '阳朔', '丹霞山', '开平', '仁化', '茂名', '湛江', '中山', '揭阳', '博罗', '阳江', '三亚', '湖南', '灵川', '虎门镇', '电白区', '潮汕地区', '保亭', '肇庆', '香港', '郴州', '资兴', '汕尾', '海口', '漳州', '梅州', '梅县区', '河源', '乳源', '龙岩', '放鸡岛', '龙脊梯田', '龙胜', '海丰', '贵州', '黄果树', '西江千户苗寨', '下川岛', '台山', '雷山', '安顺', '贵阳', '黔东南', '揭西', '江口', '长沙', '迪庆', '东源', '北海', '陆丰', '黔南', '东山', '丽江', '大理', '泉州', '雁山区', '花都区', '荔波', '湘西', '铜仁', '饶平', '玉龙', '古丈', '永顺', '涠洲岛', '泸沽湖', '张家界', '慈利', '凤凰', '香格里拉', '陵水', '从化区', '云南', '南靖', '武陵源区', '四川', '内江', '南京', '龙海', '徐闻', '柳州', '百色', '湄洲岛', '大埔', '南雄', '福安', '化州', '靖西', '漳浦', '新兴', '大新', '大理市', '南宁', '福州', '增城区', '霞浦', '吉林', '崇左', '凯里', '惠安', '云浮', '莆田', '宁德', '雷州', '资中', '通榆', '平潭', '南平', '武夷山', '龙门', '白城', '江苏'] def start_requests(self): start_urls = [] for city in self.city: for page in range(1,10): start_urls.append(f"https://vacations.ctrip.com/list/grouptravel/sc.html?from=do&st={urllib.parse.quote(city)}&sv={urllib.parse.quote(city)}&startcity=1&p=" + str(page)) 3.设置请求头使用fake_useragent来产生随机代理 Cookie是必不可少的代码如下(示例): 1.通过F12来获取Cookie

代码如下(示例):

1. 正则表达式的使用我选择用取头取尾来获取这样的正则在90%都是实用的,

2 .再使用字符串方法strip删除头和尾就取到了我们需要的json数据 6.我们遇到的第一个错觉1.并不是每个数据都是可以从html中获取的,这里遇到的难题为该价格使用js实时计算出行价格所以我们需要进入这个页面来获取此页面的json数据

2.因为是实时计算获取我们使用正则表达式和time库结合再json数据中获取每天已计算好的价格(只获取了前10天的数据)

1.再scrapy框架中item实现定义好所要获取的类

2.为了定义常用的输出数据,Scrapy提供了Item类。Item对象是种简单的容器,保存了爬取得到的数据。

3.在scrapy框架蓝图中设置我们的君子协议,(我不是君子......)

设置好robots协议和下载的秒数

4.在管道文件中我们来将数据放入到mysql中

|

【本文地址】