| Vmware添加虚拟机 | 您所在的位置:网站首页 › VMware导入别人的虚拟机 › Vmware添加虚拟机 |

Vmware添加虚拟机

|

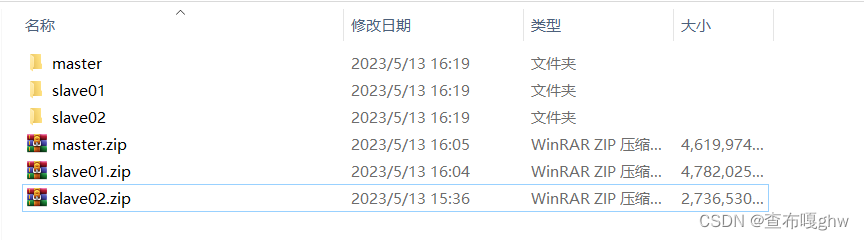

目录 1、解压copy过来的虚拟机文件: 2、加载文件: (1)鼠标左键左上角的“文件”------“打开”: (2)在打开的对话框中单击"master.vmx",然后点击"打开",如下图所示。 (3)按照上面步骤继续加载slave01和slave02 3、打开三台虚拟机: (1)打开的过程中如果报以下提醒:请点击 “我已复制虚拟机” (2)打开虚拟机:打开终端:正常网络是不需要配置的如果不通的话请查看之前的文章: (3)使用Xshell连接虚拟机: 4、修改各组件变量 (1)在Windows主机添加集群服务的IP映射 (2)修改Zookeeper的配置文件zoo.cfg (3)修改master节点配置spark-env.sh文件 1、解压copy过来的虚拟机文件:

温馨提示:如果打开的文件中有以下内容请删除:

注意:一定要修改 vi /etc/hosts 文件改为自己的ip https://blog.csdn.net/ghw666666666/article/details/127324137?spm=1001.2014.3001.5501 https://blog.csdn.net/ghw666666666/article/details/127325518?spm=1001.2014.3001.5501 (3)使用Xshell连接虚拟机:https://blog.csdn.net/ghw666666666/article/details/127326818?spm=1001.2014.3001.5501

Windows10和Windows7操作系统的路径为C:\Windows\System32\drivers\etc\hosts 在末尾添加以下内容 !!!注意要换成自己的ip 及hostname 192.168.223.146 master 192.168.223.147 slave01 192.168.223.148 slave02 (2)修改Zookeeper的配置文件zoo.cfg cd /usr/local/zookeeper/conf/ sudo vi /usr/local/zookeeper/conf/zoo.cfg在文件末尾添加如下内容: server.1=masterIP的地址:2888:3888 server.2=slave01的地址:2888:3888 server.3=slave02的地址:2888:3888 server.1=192.168.223.146:2888:3888 server.2=192.168.223.147:2888:3888 server.3=192.168.223.148:2888:3888 masterIP的地址:2888:3888 #其中master slave01 slave02为我hadoop集群中三台虚拟机的主机名 可以去 /etc/hosts中查看其中”1“,”2“,”3“使myid,要求是1~255的整数。 2888是Leader端口,负责和Follower进行通信。 3888是Follower端口,负责推选Leader。 将/usr/local/zookeeper/分发到虚拟机slave01和slave02 sudo scp -r /usr/local/zookeeper/ slave01:/usr/local sudo scp -r /usr/local/zookeeper/ slave02:/usr/local为三个脚本拥有者添加执行权限 详情请到链接:https://blog.csdn.net/ghw666666666/article/details/127352303?spm=1001.2014.3001.5501 sudo chmod u+x xzk-start.sh sudo chmod u+x xzk-stop.sh sudo chmod u+x xzk-status.sh通过脚本在虚拟机master上同时启动,关闭虚拟机 xzk-start.sh #开启 xzk-stop.sh #关闭 xzk-status.sh #查看状态 (3)修改master节点配置spark-env.sh文件 cd /usr/local/spark vim ./conf/spark-env.sh在顶部加入: #!/usr/bin/env bash export SPARK_DIST_CLASSPATH=$(/usr/local/hadoop/bin/hadoop classpath) export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop #export SPARK_MASTER_IP=192.168.223.146 //自己maser的IP export SPARK_MASTER_HOST=192.168.223.146将文件分发到各从节点: [hadoop@master local]$ tar -zcf ~/spark.master.tar.gz ./spark [hadoop@master local]$ cd [hadoop@master ~]$ scp ./spark.master.tar.gz slave01:/home/hadoop [hadoop@master ~]$ scp ./spark.master.tar.gz slave02:/home/hadoop在slave01和slave02节点上分别执行如下命令(下面以slave01为例) sudo rm -rf /usr/local/spark sudo tar -zcf spark.master.tar.gz -C /usr/local sudo chown -R hadoop:hadoop /usr/local/spark详情请到链接:https://blog.csdn.net/ghw666666666/article/details/127472243?spm=1001.2014.3001.5501 |

【本文地址】